1.

Il ne convient pas de trop demander au dilemme qui est exposé ci-dessous. La situation décrite a la nature d’une expérience de pensée. Ruwen Ogien a décrit la portée et les limites des expériences de pensée, ces « petites fictions, inventées spécialement pour susciter la perplexité morale », selon ses termes (2). Il ajoute qu’« elles nous donnent les moyens d’identifier plus clairement les facteurs qui influencent nos jugements moraux ». Quant aux expériences de pensée dans le domaine moral, leur « but ultime » est « savoir s’il y a des raisons de [conserver la réalité] comme elle est ou de la changer ».

Le « dilemme – expérience de pensée » que nous proposons (et qui a pu être déjà proposé, ce que nous ignorons au moment où nous écrivons ces lignes) vise à évaluer le rôle des émotions dans la décision que pourrait prendre l’algorithme d’un futur véhicule pleinement autonome.

Il comprend deux situations.

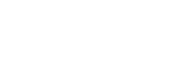

Dans la première, une voiture autonome (VA) dont les freins ont lâché est lancée en direction d’un carrefour (voir figure 1). Elle abrite deux passagers. Un piéton traverse à une courte distance, ce qu’il a le droit de faire puisque le feu est au rouge. Aucun des deux passagers de la VA n’a la possibilité de prendre le contrôle du véhicule, et, même si c’était le cas, le temps manquerait pour agir. Le pilote automatique de la VA est ainsi confronté au dilemme suivant : soit il ne change pas sa direction et le piéton sera heurté par le véhicule, soit il détourne le véhicule et, dans cette hypothèse, il est très probable que ses passagers périront car le véhicule percutera un mur. Point important, le piéton s’aperçoit que le véhicule fonce vers lui et va le percuter. Paralysé par la situation, il est saisi d’effroi et son visage exprime une émotion de peur. L’objet de sa peur est le fait qu’il subira des dommages corporels ou qu’il perdra la vie.

La seconde situation est identique à la première, à l’exception d’un trait : un camion-citerne roulant sur l’autre voie menant au carrefour, et qui est autorisé à rouler puisque le feu est vert, s’apprête à passer au niveau du piéton (voir figure 2). Si la voiture autonome poursuit sa route, elle percutera d’abord le piéton, puis le camion-citerne. Il en résultera des dommages pour le conducteur du camion, pour les deux passagers du véhicule ainsi que pour d’autres personnes se trouvant à proximité du lieu de l’accident – pour fixer les idées, une vingtaine de personnes au total sont concernées par la situation. Compte-tenu de la configuration des lieux, les capteurs de la VA sont incapables de détecter le passage du camion-citerne. Cependant, le piéton a eu le temps de saisir la situation. Il a compris que, si la VA continue sa route, les conséquences seront désastreuses non seulement pour lui, mais aussi pour toutes les personnes concernées. Paralysé par la situation, il est saisi d’effroi et son visage exprime une émotion de peur. Mais, à la différence de la première situation, l’objet de sa peur est le fait que lui-même et quantité d’autres personnes subiront des dommages corporels ou perdront la vie.

2.

Supposons que la VA soit en mesure de reconnaître les expressions faciales des êtres humains qui se situent dans son environnement. Pourrait-elle distinguer l’émotion de peur du piéton qui, dans la première situation, est seulement concerné par la préservation de son intégrité physique ou de sa vie, alors que, dans la deuxième situation, elle a pour objet la préservation d’un grand nombre de vies ? La différence entre les signaux envoyés par les piétons serait plus claire si l’émotion du piéton de la situation du camion-citerne pouvait être traduite par la requête : « Epargnez-nous ! », tandis que la requête du piéton de la première situation serait : « Epargnez-moi ! ». (Ce serait plus évident encore si les requêtes étaient respectivement : « Epargnez-nous, nous sommes vingt personnes au carrefour ! » et « Epargnez-moi, même si je suis seul au carrefour ! ».) Mais l’expression faciale de peur du second piéton ne peut exprimer le contenu de la proposition qu’il communiquerait par le langage s’il en avait la possibilité.

D’un point de vue technique, la question repose sur la capacité de la VA à saisir que l’émotion de peur du second piéton communique un signal que ne communique pas l’émotion de peur du premier piéton. Mais dans la mesure où la VA ne peut pas « percevoir » l’arrivée du camion-citerne, elle n’a, on peut le supposer, aucune « raison » de distinguer un signal dans l’expression de peur du second piéton. En outre, les passagers aussi exprimeraient de la peur. Leur émotion, comme celle de chacun des protagonistes réalisant l’horreur de la situation, paraîtrait en quelque sorte normale, voire raisonnable. Dans son ouvrage sur la rationalité des émotions, Ronald de Sousa discutait de cette question :

« On parle souvent d’une émotion particulière comme étant ‘raisonnable’. Ce que cela signifie n’est pas évident. Parfois, cela ne veut rien dire de plus que : ‘Je pourrais me sentir comme ça dans des circonstances similaires’. D’autres fois, cela reflète des normes conventionnelles plus larges mais tout aussi inarticulées : ‘Il est normal de ressentir ça’. Parfois, [‘raisonnable’] est l’équivalent de ‘approprié’. » (3)

Il ressort de son propos que l’idée que le raisonnable pourrait équivaloir au normal (« Il est normal de ressentir ça ») suggère que l’algorithme de la VA pourrait « considérer » qu’il est normal que chacun des protagonistes d’une situation d’accident ressente de la peur. Il en résulte qu’il n’y a aucune raison que la peur de l’un lui apparaisse moralement plus pertinente que la peur d’un autre. Par conséquent, la VA ne devrait pas chercher à donner un sens particulier à l’émotion éprouvée par le piéton de la situation du camion-citerne. Face au choix tragique qui s’offre à elle, elle devrait choisir, selon une perspective utilitariste, de sacrifier le piéton dans les deux situations.

3.

Que dirait de cette impasse une morale du sentiment ? Une telle morale, selon Michael Slote, « recouvre très grossièrement l’idée selon laquelle les distinctions et les motivations morales dérivent de l’émotion ou du sentiment plutôt que de la raison (pratique) » (4). Par souci d’efficacité, nous proposons quatre affirmations cohérentes avec une morale du sentiment, dont trois relèvent de l’éthique de la vertu – une théorie morale normative dont les thèses ne recouvrent pas parfaitement celles des morales du sentiment mais dont certaines versions sont qualifiées (par Slote) d’« éthiques de la vertu sentimentalistes ». Nous mentionnons le véhicule autonome dans l’énoncé de ces affirmations comme s’il disposait de la qualité d’agent :

(i) Les émotions communiquent de l’information et elles « s’infusent » par sympathie. (5)

(ii) La VA devrait manifester une « sensibilité fiable » aux exigences normatives imposées par une situation donnée. (6)

(iii) La VA devrait éprouver « les émotions appropriées, dans des circonstances appropriées, à un degré approprié, à l’attention des personnes appropriées ». (7)

(iv) La VA devrait se comporter comme le ferait une personne vertueuse.

Il faudrait beaucoup d’espace pour discuter du contenu et de la pertinence de ces affirmations. La numéro (iv), en particulier, exigerait d’une intelligence artificielle qu’elle reconnaisse les biens moraux concernés dans les situations d’accident (l’absence de tort, la préservation de soi, le respect d’autrui) et exerce les vertus permettant de réaliser ces biens. Quant à l’affirmation (iii), elle ne peut avoir du sens que si elle est interprétée (de nouveau) en un sens métaphorique, la voiture autonome ne pouvant que mimer les émotions appropriées à la situation. Cependant, si l’on remplace la VA par une personne en chair et en os, les points (i) à (iv), spécialement les (ii) et (iii), semblent correspondre à des attentes légitimes à l’égard des êtres humains confrontés à des choix moraux.

4.

D’où la question suivante : peut-on accepter de déléguer un pouvoir de décision total à des algorithmes (ceux des futurs véhicules pleinement autonomes) qui ne tiendraient pas compte les émotions éprouvées par les êtres humains, c’est-dire, pour reprendre le dilemme moral décrit précédemment, qui ne disposeraient pas d’une « sensibilité fiable » permettant de faire des distinctions entre des signaux émotionnels ? Ne devrait-on pas exiger de ces algorithmes qu’ils se conduisent comme des agents moraux disposant (métaphoriquement) de traits de caractère vertueux et de la capacité à éprouver, percevoir et interpréter des émotions ?

Si les émotions sont moralement significatives, alors les algorithmes moraux des futures voitures pleinement autonomes devraient les prendre en compte. Même la peur – une émotion apparemment instinctive, non rationnelle, que nous partageons avec les autres animaux et dont la fonction est de nous signaler un danger et de nous inviter à le fuir – possède une composante rationnelle au sens où elle permet de bien juger (8). C’est en tout cas ce que l’expérience de pensée décrite à la section 1 cherchait à illustrer. Peut-être permettra-t-elle, pour reprendre les mots de Ruwen Ogien, de susciter une perplexité morale.

Alain Anquetil

(1) Voir mon article du 23 novembre 2018.

(2) R. Ogien, L’influence de l’odeur des croissants chauds sur la bonté humaine et autres questions de philosophie morale expérimentale, Paris, Editions Grasset & Fasquelle, 2011. (3) R. de Sousa, The rationality of emotion, The Massachusetts Institute of Technology, 1987.

(4) M. Slote, « Virtue ethics and moral sentimentalism”, in S. van Hooft (dir.), The handbook of virtue ethics, Acumen Publishing Limited, 2014.

(5) Expression inspirée de David Hume (« Quand une affection s’infuse par sympathie… »), Traité de la nature humaine, vol. II : Des passions, tr. J.-P. Cléro, Paris, GF Flammarion, 1991.

(6) Expression employée par John McDowell dans son article « Virtue and reason », The Monist, 62(3), 1979, p. 331-350. Il affirme qu’« une personne bonne a une sensibilité fiable à un certain type d’exigence imposé par les situations sur le comportement ».

(7) R. Hursthouse, On virtue ethics, Oxford University Press, 1999.

(8) Voir Hursthouse, op. cit.

[cite]